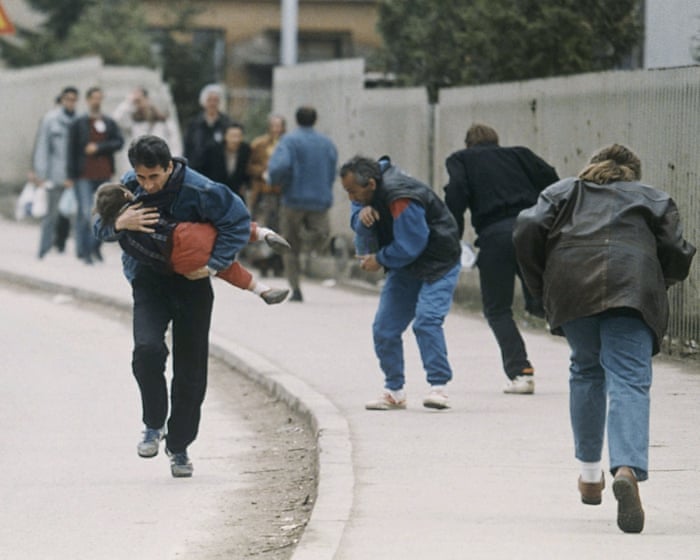

När jag var liten flicka var det inget skrämmare än en främling. Under slutet av 1980-talet och början av 1990-talet varnade våra föräldrar, TV-program och lärare oss för att främlingar ville skada oss. "Främlingfara" fanns överallt. Det var en välmenad läxa, men risken överdrevs: de flesta övergrepp mot barn begås av personer som barnet känner. Övergrepp från främlingar är mycket ovanligare.

Ovanligare, men inte omöjliga. Det vet jag för att jag utsattes för sexuella övergrepp från främlingar.

Från fem till tretton års ålder var jag barnskådespelare. Medan vi nyligen hört många skräckhistorier om övergrepp bakom kulisserna, kände jag mig alltid trygg på inspelningen. Filminspelningar var reglerade miljöer där folk fokuserade på arbetet. Jag hade stöttande föräldrar och omgavs av regissörer, skådespelare och lärare som förstod och brydde sig om barn.

Det enda sättet som showbusiness utsatte mig för fara var genom att sätta mig i offentlighetens ljus. All grymhet och exploatering jag mötte kom från allmänheten.

"Hollywood kastar dig i poolen", säger jag alltid, "men det är allmänheten som håller ditt huvud under vattnet."

Innan jag ens börjat högstadiet hade min bild använts i material för sexuella övergrepp mot barn. Jag dök upp på fetischwebbplatser och blev Photoshopad till pornografi. Vuxna män skickade läskiga brev till mig. Jag var inte en vacker flicka – min tafatta fas varade från ungefär tio till tjugofem års ålder – och jag medverkade nästan uteslutande i familjevänliga filmer. Men jag var en offentlig person, så jag var tillgänglig. Det är vad förövare letar efter: tillgång. Och inget gjorde mig mer tillgänglig än internet.

Det spelade ingen roll att bilderna "inte var jag" eller att webbplatserna var "tekniskt sett" lagliga. Det var en smärtsam, kränkande upplevelse – en levande mardröm som jag hoppades att inget annat barn skulle behöva genomlida. Som vuxen oroade jag mig för barnen som kom efter mig. Hände liknande saker med Disney-stjärnor, skådespelarna i *Stranger Things* eller förtonåringar som gjorde TikTok-danser och dök upp i familjevloggar? Jag var inte säker på att jag ville veta.

När generativ AI fick fäste för några år sedan fruktade jag det värsta. Jag hade hört talas om "deepfakes" och visste att tekniken blev exponentiellt mer realistisk.

Sedan hände det – eller åtminstone uppmärksammade världen det. Generativ AI har redan använts många gånger för att skapa sexualiserade bilder på vuxna kvinnor utan deras samtycke. Det hände med vänner till mig. Men nyligen rapporterades det att X:s AI-verktyg Grok öppet använts för att generera avklädda bilder på en minderårig skådespelare. Veckor tidigare hade en 13-årig flicka blivit utvisad från skolan för att hon slog en klasskamrat som påstods ha skapat deepfake-pornografi av henne – ungefär samma ålder som jag var när folk skapade falska sexualiserade bilder av mig.

I juli 2024 hittade Internet Watch Foundation över 3 500 AI-genererade bilder med sexuella övergrepp mot barn på ett dark web-forum. Hur många tusen till har skapats sedan dess?

Generativ AI har återuppfunnit "främlingfara". Och den här gången är rädslan befogad. Det är nu oändligt mycket lättare för vilket barn som helst vars ansikte finns på nätet att utsättas för sexuell exploatering. Miljontals barn kan tvingas leva min mardröm.

För att stoppa denna deepfake-kris måste vi undersöka hur AI tränas.

Generativ AI "lär sig" genom en upprepad process av "titta, skapa, jämför, uppdatera, upprepa", säger Patrick LaVictoire, matematiker och före detta AI-säkerhetsforskare. Den skapar modeller baserade på memoriserad information, men eftersom den inte kan memorera allt letar den efter mönster och baserar sina svar på dessa. "En koppling som..." LaVictoire förklarar att användbara AI-beteenden förstärks, medan oanvändbara eller skadliga beskärs. Vad generativ AI kan producera beror helt på dess träningsdata. En Stanford-studie från 2023 avslöjade att en populär träningsdatamängd innehöll över 1 000 fall av material med sexuella övergrepp mot barn (CSAM). Även om dessa länkar sedan tagits bort, varnar forskare för en annan fara: AI skulle kunna generera CSAM genom att kombinera oskyldiga bilder på barn med vuxenpornografi om båda typerna finns i datan.

Företag som Google och OpenAI säger att de har säkerhetsåtgärder, som att noggrant kuratera träningsdata. Det är dock viktigt att notera att bilder på många vuxna utövare och sexarbetare har skrapats för AI utan deras samtycke.

LaVictoire påpekar att generativ AI själv inte kan skilja mellan ofarliga uppmaningar, som "gör en bild på en jedi-samuraj", och skadliga, som "klä av den här kändisen". För att hantera detta kan ett annat lager av AI, liknande ett skräppostfilter, blockera sådana förfrågningar. xAI, företaget bakom Grok, verkar ha varit slapp med detta filter.

Situationen kan förvärras. Meta och andra har föreslagit att framtida AI-modeller ska vara öppen källkod, vilket innebär att vem som helst skulle kunna komma åt, ladda ner och ändra koden. Även om programvara med öppen källkod vanligtvis främjar kreativitet och samarbete, kan denna frihet bli katastrofal för barns säkerhet. En nedladdad AI-plattform med öppen källkod skulle kunna finjusteras med explicita eller olagliga bilder för att skapa obegränsat med CSAM eller "hämndporr", utan några säkerhetsåtgärder på plats.

Meta verkar ha dragit sig tillbaka från att göra sina nyare AI-plattformar helt öppen källkod. Kanske har Mark Zuckerberg funderat på det potentiella arvet och rört sig bort från en väg som skulle kunna likna honom mer vid en "Oppenheimer av CSAM" än en romersk kejsare.

Vissa länder vidtar åtgärder. Kina kräver att AI-genererat innehåll märks ut. Danmark utarbetar lagstiftning för att ge individer upphovsrätt över sin liknelse och röst, med böter för icke-kompatibla plattformar. I Europa och Storbritannien kan skydd också komma från förordningar som GDPR.

Utsikterna i USA verkar gråare. Upphovsrättsanspråk misslyckas ofta eftersom användaravtal vanligtvis ger plattformar breda rättigheter till uppladdat innehåll. Med verkställande order som motsätter sig AI-reglering och företag som xAI som samarbetar med militären, verkar den amerikanska regeringen prioritera AI-vinster framför allmänhetens säkerhet.

New York-advokaten Akiva Cohen noterar nya lagar som kriminaliserar viss digital manipulation, men säger att de ofta är alltför restriktiva. Till exempel kan det vara kriminellt att skapa en deepfake som visar någon naken eller i en sexuell handling, men att använda AI för att sätta en kvinna – eller till och med en minderårig flicka – i bikini skulle troligen inte vara det.

"Mycket av detta håller sig mycket medvetet precis på 'hemskt, men lagligt'-sidan av linjen", säger Cohen. Även om sådana handlingar kanske inte är brottsliga förseelser mot staten, hävdar Cohen att de kan vara civilrättsliga ansvarsförhållanden, som kränker en persons rättigheter och kräver ersättning. Han föreslår att detta faller under skadeståndsrättsliga förseelser som "falskt ljus" eller "intrång i privatlivet". En form av förseelse innebär att göra stötande påståenden om en person, att porträttera dem i ett falskt ljus – i huvudsak att visa någon göra något de aldrig faktiskt gjort.

"Sättet att verkligen avskräcka från detta beteende är att hålla de företag som möjliggör det ansvariga", säger Cohen.

Det finns rättspraxis för detta: New Yorks Raise Act och Kaliforniens Senate Bill 53 anger att AI-företag kan hållas ansvariga för skador de orsakar bortom en viss punkt. Samtidigt har X meddelat att de kommer att blockera sitt AI-verktyg Grok från att generera sexualiserade bilder på riktiga personer på sin plattform – även om denna policyändring inte verkar gälla den fristående Grok-appen.

Josh Saviano, en tidigare advokat i New York och före detta barnskådespelare, anser att mer omedelbara åtgärder behövs tillsammans med lagstiftning.

"Lobbyinsatser och domstolarna kommer så småningom att ta itu med detta", säger Saviano. "Men tills dess finns det två alternativ: avstå helt genom att ta bort hela ditt digitala avtryck från internet, eller hitta en teknisk lösning."

Att skydda unga människor är särskilt viktigt för Saviano, som känner personer som drabbats av deepfakes och från sin egen erfarenhet som barnskådespelare förstår hur det är att förlora kontrollen över sin egen historia. Han och hans team utvecklar ett verktyg för att upptäcka och varna människor när deras bilder eller kreativa verk skrapas på nätet. Deras motto, säger han, är: "Skydda barnen."

Hur det än sker, tror jag att att försvara sig mot detta hot kommer att kräva betydande offentliga ansträngningar.

Medan vissa börjar fästa sig vid sina AI-chattrobotar, ser de flesta människor fortfarande teknikföretag som knappt mer än verktyg. Vi kanske föredrar en app framför en annan av personliga eller politiska skäl, men starkt varumärkeslojalitet är sällsynt. Teknikföretag – särskilt sociala medieplattformar som Meta och X – borde komma ihåg att de är ett medel för att nå ett mål. Om någon som jag, som var på Twitter varje dag i över ett decennium, kan lämna det, kan vem som helst göra det.

Men bojkotter räcker inte ensamma. Vi måste kräva att företag som tillåter skapandet av material med sexuella övergrepp mot barn hålls ansvariga. Vi måste pressa för lagstiftning och tekniska säkerhetsåtgärder. Vi måste också granska vårt eget beteende: ingen vill tro att delning av bilder på sitt barn skulle kunna leda till att dessa bilder används i skadligt material. Ändå är det en verklig risk – en risk som föräldrar måste skydda små barn mot och utbilda äldre barn om.

Om vårt tidigare fokus på "främlingfara" lärde oss något, är det att de flesta människor vill förhindra att barn utsätts för fara och trakasserier. Nu är det dags att bevisa det.

Mara Wilson är en författare och skådespelare baserad i Los Angeles.

**Vanliga frågor**

Självklart. Här är en lista med vanliga frågor om det djupt oroande problemet med att personliga foton missbrukas i skadligt innehåll och det nya hotet från AI-genererade bilder.

**Förstå kärnproblemet**

**F:** Vad innebär det när någon säger att deras foto använts i material med sexuella övergrepp mot barn?

**S:** Det innebär att ett personligt, icke-sexuellt foto av dem togs utan samtycke och digitalt ändrades eller placerades i sexuellt skadliga bilder eller videor. Detta är en allvarlig form av bildbaserad sexuellt övergrepp.

**F:** Hur förvärrar AI detta problem?

**S:** AI-verktyg kan nu generera mycket realistiska falska bilder och videor. Förövare kan använda ett enda oskyldigt foto för att skapa nytt fabricerat skadligt innehåll, vilket gör att utsattheten blir oändlig och det ursprungliga fotot omöjligt att helt ta bort från cirkulation.

**F:** Jag har hört termen "deepfake" – är det vad detta är?

**S:** Ja, i detta sammanhang. En deepfake använder AI för att placera en persons ansikte på en annan persons kropp i en video eller bild. När detta görs för att skapa skadligt innehåll är det en form av digital förfalskning och ett allvarligt brott.

**För offer och de som oroar sig för att bli offer**

**F:** Vad ska jag göra om jag upptäcker att mitt foto har missbrukats på detta sätt?

**S:** 1. Ta inte bort bevis. Ta skärmdumpar med webbadresser. 2. Rapportera omedelbart till plattformen där du hittade det. 3. Gör en anmälan till polisen. 4. Kontakta en stödorganisation som Cyber Civil Rights Initiative eller RAINN för hjälp.

**F:** Kan jag få dessa AI-genererade förfalskningar borttagna från internet?

**S:** Det är utmanande men möjligt. Du måste rapportera varje förekomst till värdplattformen. Många stora plattformar har policyer mot icke-konsensuell intim bild. Det finns också tjänster som Take It Down som kan hjälpa till att förhindra att kända bilder delas.

**F:** Hur kan jag skydda mina foton från att missbrukas av AI?

**S:** Även om ingen metod är idiotsäker kan du vara mycket selektiv med vad du delar offentligt online, använda strikta sekretessinställningar, undvika att publicera högupplösta foton och överväga att använda digitala vattenstämplar. Var försiktig med appar som använder...