Kiedy byłam małą dziewczynką, nic nie było straszniejsze od obcego. W późnych latach 80. i wczesnych 90. nasi rodzice, programy telewizyjne i nauczyciele ostrzegali nas, że obcy chcą nas skrzywdzić. "Niebezpieczeństwo od obcych" było wszędzie. To była płynąca z dobrych intencji lekcja, ale ryzyko było wyolbrzymione: większość przypadków wykorzystywania dzieci jest popełnianych przez osoby, które dziecko zna. Nadużycia ze strony obcych są znacznie rzadsze.

Rzadsze, ale nie niemożliwe. Wiem to, ponieważ padłam ofiarą wykorzystywania seksualnego przez obcych.

W wieku od pięciu do 13 lat byłam dzieckiem aktorką. Chociaż ostatnio słyszymy wiele przerażających historii o nadużyciach za kulisami, ja zawsze czułam się bezpiecznie na planie. Plany filmowe były uregulowanymi przestrzeniami, gdzie ludzie skupiali się na pracy. Miałam wspierających rodziców i byłam otoczona przez reżyserów, aktorów i nauczycieli, którzy rozumieli i troszczyli się o dzieci.

Jedyny sposób, w jaki show-biznes mnie narażał, to wystawianie mnie na widok publiczny. Wszelkie okrucieństwo i wykorzystywanie, z którymi się spotkałam, pochodziły od społeczeństwa.

"Hollywood wrzuca cię do basenu" – zawsze mówię – "ale to społeczeństwo trzyma twoją głowę pod wodą".

Zanim jeszcze zaczęłam szkołę średnią, mój wizerunek został użyty w materiałach przedstawiających seksualne wykorzystywanie dzieci. Pojawiałam się na stronach fetyszowych i byłam fotomontowana do pornografii. Dorośli mężczyźni przysyłali mi przerażające listy. Nie byłam piękną dziewczynką – mój nieporadny etap trwał od około 10. do 25. roku życia – i grałam prawie wyłącznie w filmach familijnych. Ale byłam osobą publiczną, więc byłam dostępna. Tego właśnie szukają drapieżcy: dostępu. A nic nie uczyniło mnie bardziej dostępną niż internet.

Nie miało znaczenia, że te obrazy "nie były mną" lub że strony były "technicznie" legalne. To było bolesne, naruszające doświadczenie – żywy koszmar, którego miałam nadzieję, że żadne inne dziecko nie będzie musiało znosić. Jako dorosła osoba martwiłam się o dzieci, które przyszły po mnie. Czy podobne rzeczy działy się gwiazdom Disneya, obsadzie *Stranger Things* lub nastolatkom tworzącym tańce na TikToku i pojawiającym się w rodzinnych vlogach? Nie byłam pewna, czy chcę to wiedzieć.

Kiedy kilka lat temu generatywna sztuczna inteligencja zyskała na popularności, obawiałam się najgorszego. Słyszałam o "deepfake'ach" i wiedziałam, że technologia staje się wykładniczo bardziej realistyczna.

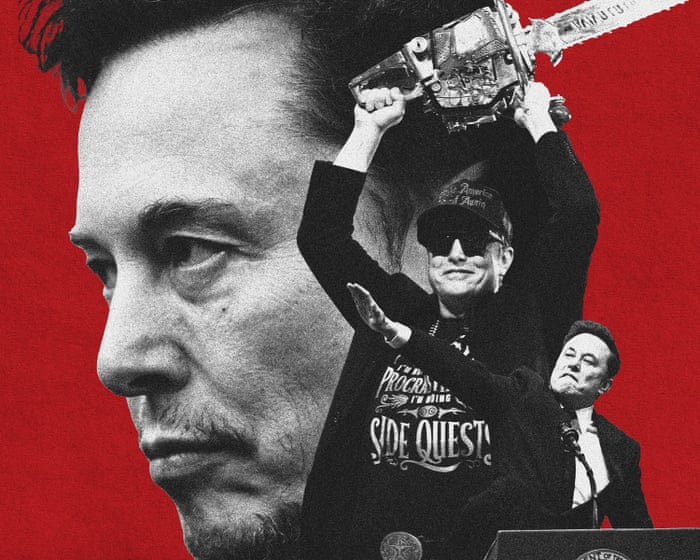

A potem to się stało – a przynajmniej świat to zauważył. Generatywna sztuczna inteligencja była już wielokrotnie używana do tworzenia seksualizowanych obrazów dorosłych kobiet bez ich zgody. Przydarzyło się to moim przyjaciółkom. Ale niedawno doniesiono, że narzędzie AI X-a, Grok, zostało użyte otwarcie do generowania rozebranych obrazów nieletniej aktorki. Kilka tygodni wcześniej 13-letnia dziewczynka została wydalona ze szkoły za uderzenie koleżanki, która rzekomo stworzyła deepfake'ową pornografię z jej udziałem – mniej więcej w tym samym wieku, w jakim byłam, gdy ludzie tworzyli fałszywe seksualizowane obrazy ze mną.

W lipcu 2024 roku Internet Watch Foundation znalazła ponad 3500 wygenerowanych przez AI obrazów przedstawiających seksualne wykorzystywanie dzieci na forum dark webu. Ile tysięcy więcej powstało od tego czasu?

Generatywna sztuczna inteligencja na nowo wynalazła "Niebezpieczeństwo od obcych". I tym razem strach jest uzasadniony. Obecnie jest nieskończenie łatwiej, aby każde dziecko, którego twarz jest w internecie, padło ofiarą wykorzystywania seksualnego. Miliony dzieci mogą być zmuszone do przeżywania mojego koszmaru.

Aby powstrzymać ten kryzys deepfake'ów, musimy przyjrzeć się temu, jak szkolona jest sztuczna inteligencja.

Generatywna sztuczna inteligencja "uczy się" poprzez powtarzany proces "patrz, twórz, porównuj, aktualizuj, powtarzaj", mówi Patrick LaVictoire, matematyk i były badacz bezpieczeństwa AI. Tworzy modele na podstawie zapamiętanych informacji, ale ponieważ nie może zapamiętać wszystkiego, szuka wzorców i opiera swoje odpowiedzi na nich. "Połączenie, które jest..." LaVictoire wyjaśnia, że pożyteczne zachowania AI są wzmacniane, podczas gdy nieprzydatne lub szkodliwe są przycinane. To, co generatywna AI może wytworzyć, zależy całkowicie od jej danych treningowych. Badanie Stanforda z 2023 roku ujawniło, że popularny zbiór danych treningowych zawierał ponad 1000 przypadków materiałów przedstawiających seksualne wykorzystywanie dzieci (CSAM). Chociaż te linki zostały od tego czasu usunięte, badacze ostrzegają przed innym niebezpieczeństwem: AI mogłaby generować CSAM, łącząc niewinne obrazy dzieci z pornografią dla dorosłych, jeśli oba typy są obecne w danych.

Firmy takie jak Google i OpenAI twierdzą, że mają zabezpieczenia, takie jak staranne kuratorowanie danych treningowych. Jednak warto zauważyć, że obrazy wielu dorosłych wykonawców i pracowników seksualnych zostały pozyskane dla AI bez ich zgody.

LaVictoire wskazuje, że sama generatywna sztuczna inteligencja nie może odróżnić nieszkodliwych poleceń, takich jak "stwórz obraz samuraja Jedi", od szkodliwych, takich jak "rozbierz tę celebrytkę". Aby temu zaradzić, dodatkowa warstwa AI, podobna do filtru spamowego, może blokować takie zapytania. xAI, firma stojąca za Grokiem, wydaje się, że była pobłażliwa wobec tego filtru.

Sytuacja może się pogorszyć. Meta i inni zaproponowali, aby przyszłe modele AI były open source, co oznacza, że każdy mógłby uzyskać dostęp, pobrać i zmodyfikować kod. Chociaż oprogramowanie open source zazwyczaj sprzyja kreatywności i współpracy, ta wolność mogłaby być katastrofalna dla bezpieczeństwa dzieci. Pobrana, open-source'owa platforma AI mogłaby być dostrojona za pomocą wyraźnych lub nielegalnych obrazów, aby tworzyć nieograniczone CSAM lub "pornografię zemsty", bez żadnych zabezpieczeń.

Meta wydaje się wycofywać z uczynienia swoich nowszych platform AI w pełni open source. Być może Mark Zuckerberg rozważył potencjalne dziedzictwo, odchodząc od ścieżki, która mogłaby przyrównać go bardziej do "Oppenheimera CSAM" niż do rzymskiego cesarza.

Niektóre kraje podejmują działania. Chiny wymagają oznaczania treści generowanych przez AI. Dania opracowuje przepisy, które nadadzą osobom prawo autorskie do ich podobizny i głosu, z karami dla niespełniających wymogów platform. W Europie i Wielkiej Brytanii ochronę mogą również zapewniać przepisy takie jak RODO.

Perspektywy w Stanach Zjednoczonych wydają się ponurejsze. Roszczenia z tytułu praw autorskich często nie udają się, ponieważ umowy użytkownika zazwyczaj przyznają platformom szerokie prawa do przesłanych treści. Przy rozporządzeniach wykonawczych sprzeciwiających się regulacji AI i firmach takich jak xAI współpracujących z wojskiem, rząd USA wydaje się priorytetowo traktować zyski z AI ponad bezpieczeństwo publiczne.

Prawnik z Nowego Jorku, Akiva Cohen, zauważa ostatnie ustawy, które kryminalizują niektóre manipulacje cyfrowe, ale mówi, że są one często zbyt restrykcyjne. Na przykład, stworzenie deepfake'a pokazującego kogoś nagiego lub w akcie seksualnym może być przestępstwem, ale użycie AI do umieszczenia kobiety – a nawet nieletniej dziewczynki – w bikini prawdopodobnie nie byłoby.

"Duża część tego bardzo świadomie pozostaje tuż po stronie 'przerażające, ale legalne' tej granicy" – mówi Cohen. Chociaż takie czyny mogą nie być przestępstwami przeciwko państwu, Cohen twierdzi, że mogą być one odpowiedzialnością cywilną, naruszającą prawa osoby i wymagającą zadośćuczynienia. Sugeruje, że to mieści się w zakresie deliktów, takich jak "fałszywe światło" lub "naruszenie prywatności". Jedną z form wykroczeń jest składanie obraźliwych twierdzeń na temat osoby, przedstawianie jej w fałszywym świetle – w zasadzie pokazywanie kogoś robiącego coś, czego nigdy tak naprawdę nie zrobił.

"Prawdziwym sposobem na odstraszenie od tego rodzaju zachowań jest pociągnięcie do odpowiedzialności firm, które je umożliwiają" – mówi Cohen.

Istnieje precedens prawny: ustawa Raise Act w Nowym Jorku i ustawa senacka 53 w Kalifornii stanowią, że firmy AI mogą być pociągnięte do odpowiedzialności za szkody, które powodują po przekroczeniu pewnego punktu. Tymczasem X ogłosił, że zablokuje swojemu narzędziu AI Grok generowanie seksualizowanych obrazów prawdziwych ludzi na swojej platformie – chociaż ta zmiana polityki wydaje się nie dotyczyć samodzielnej aplikacji Grok.

Josh Saviano, były prawnik w Nowym Jorku i były dziecięcy aktor, uważa, że oprócz ustawodawstwa potrzebne są bardziej natychmiastowe działania.

"Zabiegi lobbingowe i sądy ostatecznie się tym zajmą" – mówi Saviano. "Ale do tego czasu są dwie opcje: całkowicie powstrzymać się, usuwając cały swój cyfrowy ślad z internetu, albo znaleźć rozwiązanie technologiczne."

Ochrona młodych ludzi jest szczególnie ważna dla Saviano, który zna osoby dotknięte deepfake'ami i z własnego doświadczenia jako dziecięcy aktor rozumie, jak to jest stracić kontrolę nad własną historią. On i jego zespół opracowują narzędzie do wykrywania i ostrzegania ludzi, gdy ich obrazy lub twórczość są pozyskiwane w internecie. Ich motto, jak mówi, brzmi: "Chrońcie dzieci."

Jakkolwiek by to się nie stało, wierzę, że obrona przed tym zagrożeniem będzie wymagać znacznego wysiłku publicznego.

Podczas gdy niektórzy przywiązują się do swoich chatbotów AI, większość ludzi nadal postrzega firmy technologiczne jako coś niewiele więcej niż narzędzia. Możemy preferować jedną aplikację nad drugą z powodów osobistych lub politycznych, ale silna lojalność wobec marki jest rzadka. Firmy technologiczne – zwłaszcza platformy społecznościowe takie jak Meta i X – powinny pamiętać, że są środkiem do celu. Jeśli ktoś taki jak ja, kto był na Twitterze codziennie przez ponad dekadę, może go opuścić, to każdy może.

Ale same bojkoty nie wystarczą. Musimy domagać się, aby firmy umożliwiające tworzenie materiałów przedstawiających seksualne wykorzystywanie dzieci zostały pociągnięte do odpowiedzialności. Musimy naciskać na ustawodawstwo i zabezpieczenia technologiczne. Musimy również przyjrzeć się własnemu zachowaniu: nikt nie chce myśleć, że udostępnianie zdjęć swojego dziecka może prowadzić do użycia tych obrazów w materiałach nadużyć. A jednak to realne ryzyko – przed którym rodzice muszą chronić małe dzieci i o którym muszą edukować starsze dzieci.

Jeśli nasze przeszłe skupienie na "Niebezpieczeństwie od obcych" czegoś nas nauczyło, to tego, że większość ludzi chce zapobiegać narażaniu i nękaniu dzieci. Teraz nadszedł czas, aby to udowodnić.

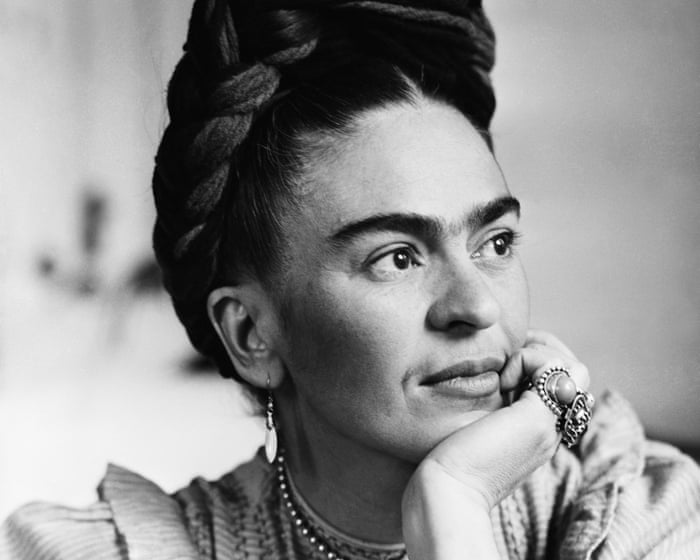

Mara Wilson jest pisarką i aktorką mieszkającą w Los Angeles.

**Często zadawane pytania**

Oczywiście Oto lista często zadawanych pytań dotyczących głęboko niepokojącego problemu niewłaściwego wykorzystywania osobistych zdjęć w treściach nadużyć oraz nowego zagrożenia stwarzanego przez obrazy generowane przez AI

**Zrozumienie podstawowego problemu**

**P: Co to znaczy, gdy ktoś mówi, że jego zdjęcie zostało użyte w materiale przedstawiającym wykorzystywanie dzieci?**

O: Oznacza to, że osobiste, nieseksualne zdjęcie tej osoby zostało pobrane bez zgody i cyfrowo zmienione lub umieszczone w seksualnie nadużywających obrazach lub filmach. To poważna forma nadużycia seksualnego opartego na obrazie.

**P: W jaki sposób AI pogarsza ten problem?**

O: Narzędzia AI mogą teraz generować wysoce realistyczne fałszywe obrazy i filmy. Sprawcy mogą użyć jednego niewinnego zdjęcia, aby tworzyć nowe, sfabrykowane treści nadużyć, czyniąc wiktymizację nieskończoną, a oryginalne zdjęcie niemożliwym do całkowitego usunięcia z obiegu.

**P: Słyszałem termin "deepfake" – czy to jest to?**

O: Tak, w tym kontekście. Deepfake używa AI do nałożenia twarzy osoby na ciało innej osoby w filmie lub obrazie. Kiedy robi się to w celu stworzenia treści nadużyć, jest to forma fałszerstwa cyfrowego i poważne przestępstwo.

**Dla ofiar i osób martwiących się, że staną się ofiarą**

**P: Co powinienem zrobić, jeśli odkryję, że moje zdjęcie zostało niewłaściwie użyte w ten sposób?**

O: 1. Nie usuwaj dowodów. Zrób zrzuty ekranu z adresami URL. 2. Natychmiast zgłoś to na platformie, gdzie to znalazłeś. 3. Złóż zgłoszenie do organów ścigania. 4. Skontaktuj się z organizacją wsparcia, taką jak Cyber Civil Rights Initiative lub RAINN, po pomoc.

**P: Czy mogę usunąć te wygenerowane przez AI fałszywki z internetu?**

O: To trudne, ale możliwe. Musisz zgłosić każdą instancję do platformy hostingowej. Wiele głównych platform ma polityki przeciwko niekonsensualnym intymnym obrazom. Istnieją również usługi takie jak Take It Down, które mogą pomóc w zapobieganiu udostępnianiu znanych obrazów.

**P: Jak mogę chronić swoje zdjęcia przed niewłaściwym wykorzystaniem przez AI?**

O: Chociaż żadna metoda nie jest niezawodna, możesz być bardzo selektywny w tym, co udostępniasz publicznie online, używać ścisłych ustawień prywatności, unikać publikowania zdjęć w wysokiej rozdzielczości i rozważyć użycie cyfrowych znaków wodnych. Zachowaj ostrożność wobec aplikacji, które używają...